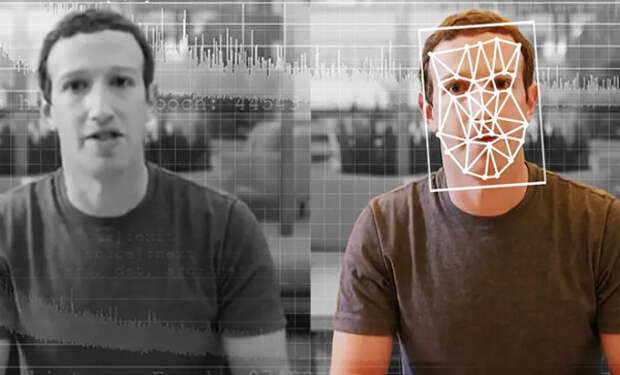

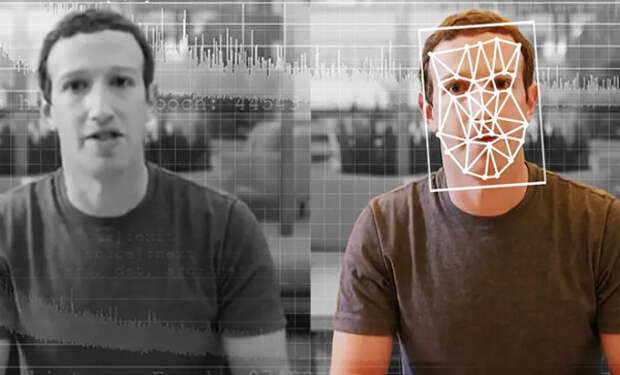

Дипфейки из редких диковин превратились в повседневность, поскольку технологии искусственного интеллекта сегодня доступны каждому. Многие начали использовать его для манипулирования зрителями — широко, к примеру, распространилось фейковое видео, где Марго Робби моет пол. Отличать реальность от вымысла теперь необходимый базовый навык: эксперты собрали 6 главных признаков, которые позволят определить подделку.

Один из самых простых способов определить, что видео является дипфейком, — проверить форму лица. Сложнее всего ИИ удаются уши, обычно они оказываются непропорциональными.

Обратный поиск также может помочь узнать правду. Скриншот ключевой части видео и затем поиск в Google, YouTube и TikTok должны дать результат.

Внимательно изучайте выражения и манеры поведения. Это поможет, если на видео фигурирует знаменитость или общественный деятель. Обычно их типичные привычки хорошо известны.

У дипфейков часто возникают проблемы с положением глаз. Попробуйте остановить видео и проверьте, смотрят ли глаза в одном направлении.

Видео Deepfake могут выглядеть убедительно, когда человек смотрит в камеру, но технология может дать сбой, когда он поворачивается в сторону. В этот момент, если присмотреться, становятся заметны точки, в которых технология не может идеально сопоставить лицо, сгенерированное ИИ, с реальной частью видео.

Наконец, специалисты рекомендуют проанализировать артикуляцию на видео. Даже самые продвинутые дипфейки пока не способны полностью синхронизировать движения губ с каждой фразой. Около трети дипфейковых видео имеют несоответствие букв М, Б или Р.

В течение многих лет людям говорили не верить всему, что они видят в интернете. Теперь это предупреждение выходит на новый уровень — подделок становится слишком много.

источник

Один из самых простых способов определить, что видео является дипфейком, — проверить форму лица. Сложнее всего ИИ удаются уши, обычно они оказываются непропорциональными.

Обратный поиск также может помочь узнать правду. Скриншот ключевой части видео и затем поиск в Google, YouTube и TikTok должны дать результат.

Внимательно изучайте выражения и манеры поведения. Это поможет, если на видео фигурирует знаменитость или общественный деятель. Обычно их типичные привычки хорошо известны.

У дипфейков часто возникают проблемы с положением глаз. Попробуйте остановить видео и проверьте, смотрят ли глаза в одном направлении.

Видео Deepfake могут выглядеть убедительно, когда человек смотрит в камеру, но технология может дать сбой, когда он поворачивается в сторону. В этот момент, если присмотреться, становятся заметны точки, в которых технология не может идеально сопоставить лицо, сгенерированное ИИ, с реальной частью видео.

Наконец, специалисты рекомендуют проанализировать артикуляцию на видео. Даже самые продвинутые дипфейки пока не способны полностью синхронизировать движения губ с каждой фразой. Около трети дипфейковых видео имеют несоответствие букв М, Б или Р.

В течение многих лет людям говорили не верить всему, что они видят в интернете. Теперь это предупреждение выходит на новый уровень — подделок становится слишком много.

источник

Свежие комментарии